Vitis AI 2.0 现已推出!

Vitis AI 2.0 现已推出!作为 Xilinx FPGA 及自适应 SoC 上基于软件的最全面 AI 加速解决方案,Vitis AI 将不断提高用户 AI 产品的价值和竞争力。有了该版本,Vitis AI 解决方案不仅更加简单易用,而且还可在边缘和数据中心实现进一步的性能提升。本次网络研讨会将介绍新产品的特性,包括模型、软件工具、深度学习处理单元以及最新性能信息等。

Vitis AI 2.0 版本的主要特性:

- 通过更好的 CPU OP 流程显著提升了模型覆盖率,同时支持了 Tensorflow 框架内推理机制;

- 新增 20 个先进的 AI 模型,用于 CNN 和 NLP 中的传感器融合、视频分析、超分辨率和情感估计应用;

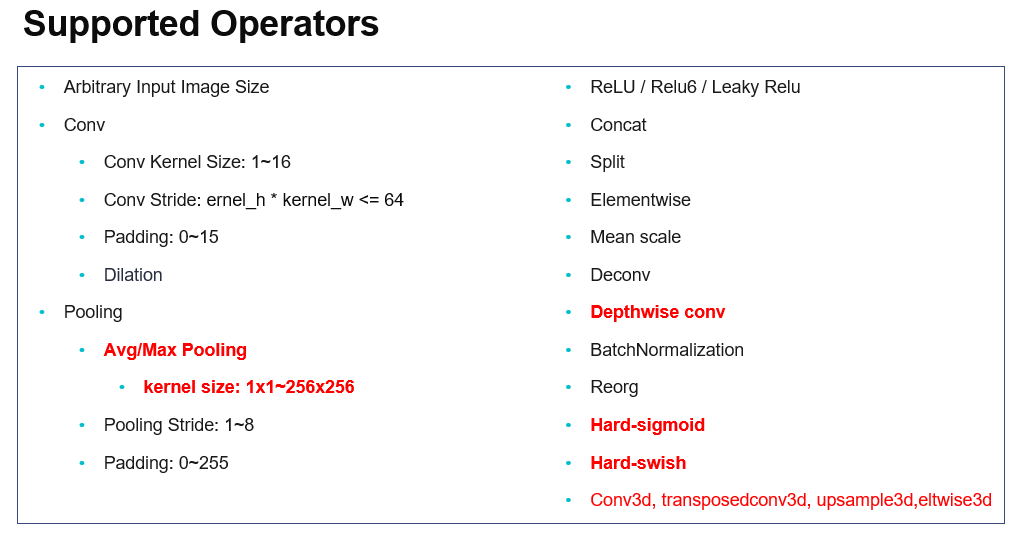

- 在 VCK190 和 VCK5000 硬件平台上提供了灵活的 DPU IP 配置及新功能,包括支持 3D 卷积、depthwise 卷积等,可满足更多需求。

如欲抢先了解所有全新特性,请查看完整的版本说明。

易用性取得突破性进展

自定义 OP 插件

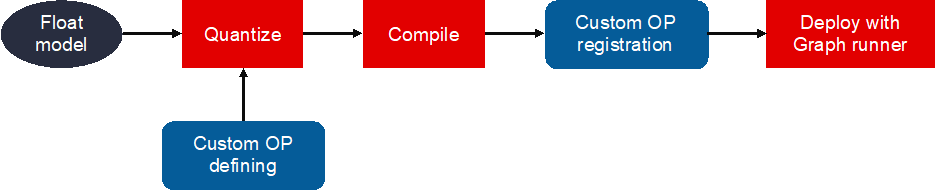

熟悉 Vitis AI 的用户了解,这个工具和 IP 有时会遇到不支持的网络层,导致部署失败。不受 Vitis AI 工具与 DPU IP 支持的这些网络层将被逐一划分给 CPU 处理器,用户需要手动处理 DPU 和 CPU 之间的数据交换,这个过程会影响用户体验。

在 Vitis AI 2.0 中,自定义 OP 流程提供更简便的模型部署途径。对于 DPU 不支持的 OP,这种方法在用 Graph Runner 对它们进行部署之前,先在量化流中定义这些 OP,然后完成注册和实现。通过这种方法,用户可以轻松部署完整模型,避免在流程中出错。

WeGO Tensorflow 推理流程

新版本中在易用性方面取得突破性进展的另一体现是引入了全图形优化器 (WeGO) 流。这是将 Vitis AI 开发套件与该框架集成后,从 Tensorflow 直接推断的结果。在 Vitis AI 2.0 中,WeGO 可用于 TensorFlow 1.x 框架以及数据中心版本 DPU 上的 AI 推断。

WeGO 自动为 Vitis AI 量化器量化的模型执行子图划分,可以优化并加速数据中心端 DPU 子图应用。DPU 不支持的图形部分将拆分给 Tensorflow,在 CPU 上执行。整个过程对用户完全透明,依托对框架内原生的所有层的支持,以及数据中心端 DPU 上更优异的性能,整体易用性得到了进一步提升。

全新模型

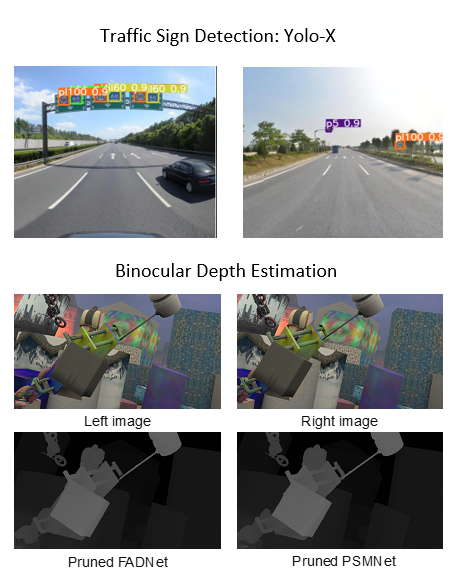

AI 模型库已成为 Vitis AI 堆栈中用户最常使用的组件之一。它提供了能够适用于多种视觉场景的免费、开放且可再训练的优化模型。在 Vitis AI 2.0 版本中,免费模型的数量已增至 130 个,覆盖主流框架 Pytorch、Tensorflow、Tensorflow 2 和 Caffe 。

部分新增模型如 SOLO、Yolo-X、UltraFast、CLOC、SESR、 DRUNet、SSR、FADNet、PSMNet、FairMOT。这些模型可广泛用于目标检测、分割、激光雷达成像传感器融合、医疗成像处理、基于 2D 和 3D 的深度估算、用于情感检测再识别、客户满意度和开放信息提取的NLP模型等。除了这些经过训练的模型,新版本也提供了能够提高模型准确性与硬件性能的 OFA 搜索模型。

如欲了解更多 AI 模型信息,以及 Vitis AI 正式支持的硬件上的部署性能,请登录 Github,查看 AI 模型专区。

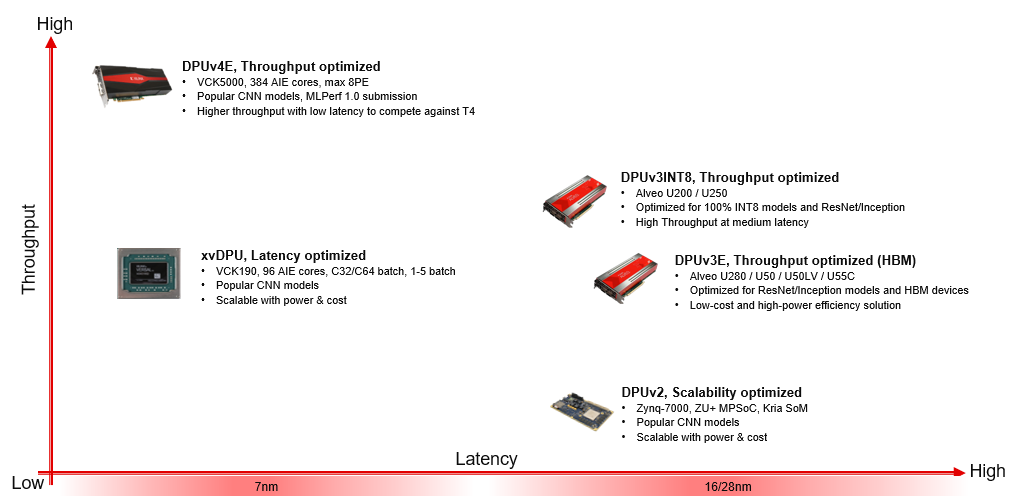

DPU 可扩展性与新硬件平台

Vitis AI 2.0 新增对 VCK190、VCK5000 量产板和新硬件 Alveo U55c 的支持。到目前,从嵌入式到数据中心,Vitis AI 全面支持所有主要的器件或加速器卡,包括 Zynq Ultrascale+ MPSoC、Versal ACPA 和 Alveo 卡。

边缘和云平台上的 DPU IP 都已升级以实现更多功能,如 Conv3D、Depthwise Conv、h-sigmoid、h-swish 等。Versal Edge DPU 能从 Batch 1 到 Batch 5 支持 C32 模式和 C64 模式,加强 DPU 与定制应用集成的灵活性。

不仅如此!解锁更多功能!

除了上述新特性,赛灵思还改进了 Vitis AI 工具链的功能与性能,由此 AI 量化器与编译器均支持自定义 OP,且都支持更高版本的 Pytorch (v1.8-1.9) 和 Tensorflow (v2.4-2.6)。 AI 编译器、基于全新算法的 Optimizer、AI Library、VART、AI Profiler 和 WAA 都支持本次发布的新增模型和自定义OP 流程等。

登录 Xilinx.com 并启动设计!下载最新 docker 图像并了解 Vitis AI 2.0 的功能。